AI服务器产业链

科技先锋

来源:天风证券

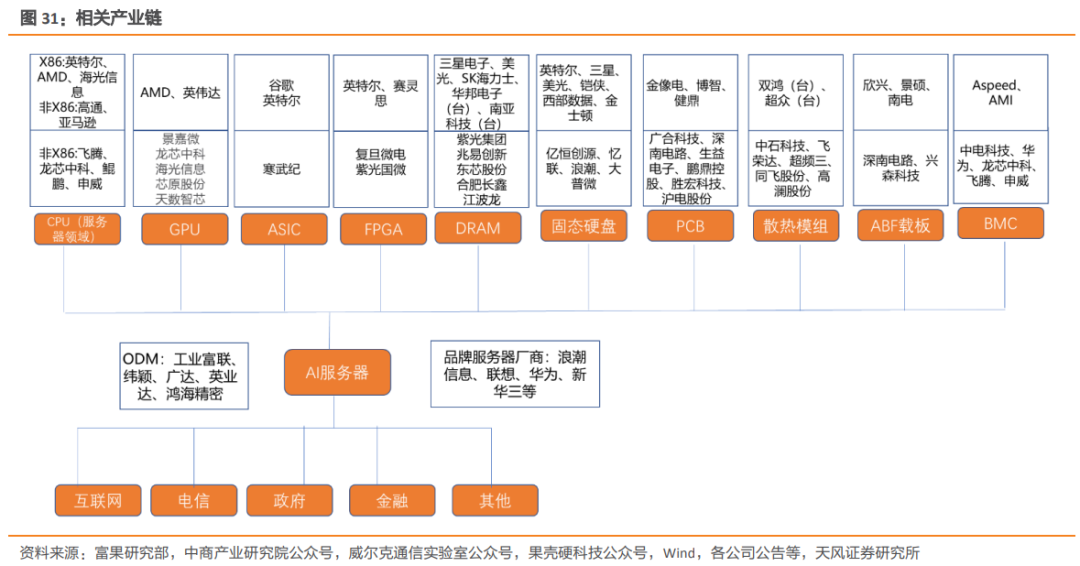

在算力和数字时代的背景下,AI 服务器作为算力载体为数字经济提供发展动力,更加彰显其重要性。纵观 AI 服务器的全景产业链,我们认为当下可以把握的机遇有 AI 服务器上游中部分电子元件环节(PCB/存储器),制约 AI 服务器发展的瓶颈主要在上游的 GPU 环节,未来有望突破的转折为 Chiplet 工艺。

由于 CPU 并不适合 AI 服务器中的大规模并行计算,因此在 AI 服务器中,主要是用 GPU、FPGA、ASIC 等计算芯片补齐 CPU 中人工智能负载处理的短板。在国家政策支持+资本推动+产业链和应用场景持续完善扩张的驱动 下,中国 AI 芯片需求有望持续上涨。

据 IDC 调研显示,当前每台人工智能服务器上配备 2 个 GPU、3 个 FPGA 或 3 个 ASIC 的比例最高,未来 18 个月,比例最高的服务器有望配备 4 个 GPU、7 个 FPGA 或 5 个 ASIC,普遍搭载率均呈上升趋势。

GPU 主要分为独立 GPU 和集成 GPU,前者用于 AI 服务器、高性能电脑中,后者则主要用于移动端设备。目前 Nvidia 和 AMD 垄断独立 GPU 市场,其中 Nvidia 优势更为明显,2021Q1 市占率达到 83%。同时, 据电子发烧网,Nvidia的GPU芯片是AI大模型的关键,在大模型训练市场的市占比近100%, 而 GPT-3.5 大模型需要高达 2 万枚 GPU,未来商业化后或将超过 3 万枚。同时国内如浪潮、宁畅等国内品牌厂商的 AI 服务器中同样配置 Nvidia 的芯片。

伴随资本和政策的持续加码,一批国内 GPU 厂商逐渐崭露头角(见下表)。然而,我们仍需看到在芯片设计制造领域,我国仍缺乏设计软件、先进制程及设备与世界领先水平之间仍有差距,该领域部分产品及装备仍十分依赖进口,国产 GPU 之路仍是路漫漫其修远兮。

我们认为,采用 Chiplet,即将模块化设计引入半导体制造和制造,协同计算助力 HPC 芯片算力突破及性能提升,从而满足大型模型的训练需求。Chiplet 工艺有望突破国产芯片的算力瓶颈,成为半 导体发展核心,2022 年 12 月中国工信部中国电子工业标准化技术协会审定并发布了《小 芯片接口总线技术要求》,中国迎来了首个原生 Chiplet 小芯片标准。该推广将推动本土半 导体芯片这一领域的发展。

PCB 主要参与服务器内部的主板、电源背板、硬盘背板、网卡、Riser卡等,随着服务器对运算及传输速率的要求不断提升,对 PCB 提出更严苛的电性能要求,同时也给对应的 PCB 市场带来良好机会。

散热效率一直是服务器厂商需要解决的问题之一,当前主流模式是利用散热鳍片、热导管、风扇、空调等组成的风冷模式。随着大数据、云计算带来天量的数据处理等高通量的计算业务,使得服务器芯片的散热受到严重挑战,芯片热 封装壳温也在不断提高,达到了风冷的极限。同时风冷的耗电量极高,数据中心的制冷空调系统用电量占整个数据中心的 30-50%。相比之下,液体比热容为空气的 1000-3500 倍, 导热性能是空气的 15-25 倍,利用自然冷却显著降低耗电量,使得液冷成为风冷的不二选择,在未来或将全面替代风冷,成为 AI 服务器乃至数据中心的标配。

服务器内的数据存力重要性成为存储器发展动力。在服务器行业,既需要高频宽的 DRAM 作为暂存,提供处理器技术时即时所需的资料;也需要 NAND Flash 用以存放资料,通常以固态硬盘(SSD)的形态存在。

展开阅读全文

文章观点仅代表作者观点,或基于大数据智能生产,不构成投资建议。投资者依据此做出的投资决策需自担风险,与通联数据无关。